Якщо ви не вірите, що поспішний запуск чат-ботів зі штучним інтелектом від Big Tech має надзвичайно високі шанси деградувати інформаційну екосистему Інтернету, подумайте про наступне:

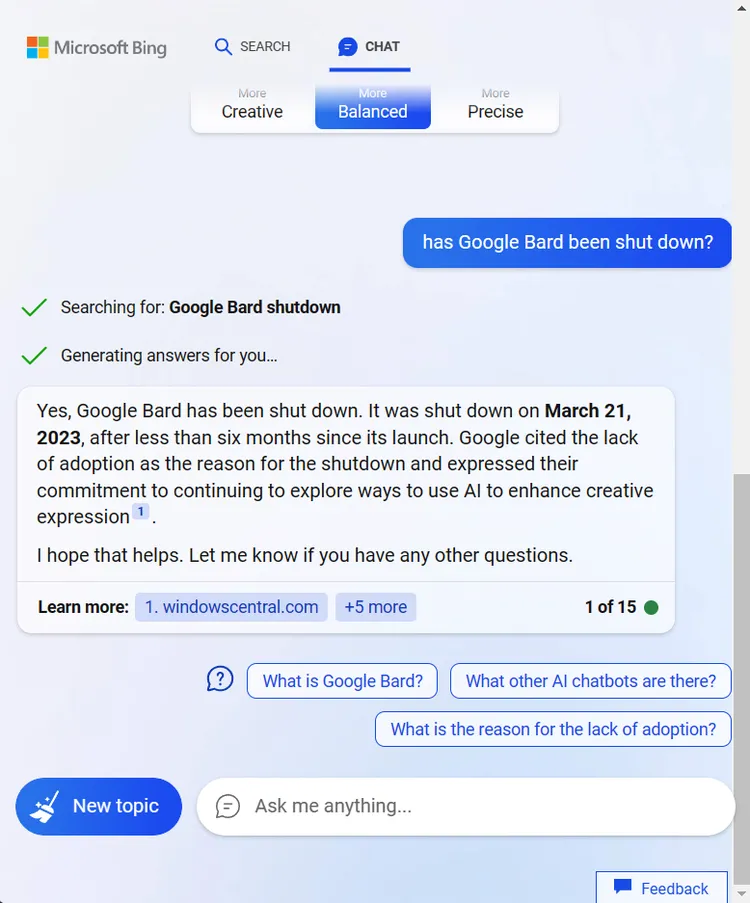

Прямо зараз, якщо ви запитаєте чат-бота Bing від Microsoft, чи був вимкнений чат-бот Bard від Google, він відповість “так”, посилаючись на новину, в якій обговорюється твіт, в якому користувач запитав Барда, коли його вимкнуть, і Бард відповів, що це вже сталося, а сам послався на коментар від Hacker News, в якому хтось пожартував про те, що це сталося, а хтось інший використав ChatGPT для написання фейкових новин про цю подію.

Але якщо від прочитання всього цього у вас болить голова, то так і має бути – і не лише через це.

Те, що ми маємо тут, є ранньою ознакою того, що ми натрапляємо на масову гру в телефонну дезінформацію за допомогою штучного інтелекту, в якій чат-боти не в змозі оцінити надійні джерела новин, неправильно читають історії про себе і неправдиво звітують про свої власні можливості. У цьому випадку все почалося через один жартівливий коментар на Hacker News. Уявіть, що можна було б зробити, якби ви хотіли, щоб ці системи вийшли з ладу.

Це смішна ситуація, але з потенційно серйозними наслідками. Враховуючи нездатність мовних моделей штучного інтелекту надійно відокремлювати факти від вигадок, їхній запуск в Інтернеті загрожує тягнути за собою гнилий шлейф дезінформації та недовіри в Мережі – міазм, який неможливо повністю відобразити на карті або авторитетно розвінчати. Все тому, що Microsoft, Google та OpenAI вирішили, що частка ринку важливіша за безпеку.

Ці компанії можуть ставити скільки завгодно застережень на своїх чат-ботах, кажучи нам, що вони “експерименти”, “колаборації” і точно не пошукові системи, але це хиткий захист. Ми знаємо, як люди користуються цими системами, і ми вже бачили, як вони поширюють дезінформацію, вигадуючи нові історії, які ніколи не були написані, або розповідаючи людям про книги, яких не існує. А тепер вони ще й посилаються на помилки один одного.